Pourquoi dbt s’impose dans la data moderne

Depuis son lancement, dbt (Data Build Tool) s’est imposé comme un élément incontournable dans la transformation et la gouvernance des données en entreprise. Où que l’on regarde, de la startup à la grande organisation, dbt occupe le centre du Modern Data Stack. Sa promesse : permettre aux équipes data de transformer, valider et documenter leurs données au sein même de l’entrepôt cloud (BigQuery, Redshift, Snowflake…), tout en adoptant les meilleures pratiques du monde logiciel : versioning, tests automatiques, modélisation modulaire, documentation vivante et auditabilité native.

Avec dbt, la donnée devient un actif vivant :

- Le paradigme ELT (Extract, Load, Transform) rend les traitements plus rapides et plus scalables que les anciens ETL.

- La transformation SQL est collaborative : la data team, analytics engineers et métiers travaillent ensemble, via Git et outils standards.

- La documentation et les tests deviennent intégrés — plus de silos : chaque modèle, chaque règle de gestion, chaque table est transparente, testée et versionnée.

dbt, socle de la Data Mesh et pont vers l’AI-ready

dbt n’est pas seulement un outil technique. Il est au cœur de la transformation organisationnelle de la donnée : il libère les métiers, rend la data gouvernable à grande échelle, et anticipe les enjeux d’IA et d’autonomisation. dbt a permis l’émergence de l’Analytics Engineering, accélérant la création de valeur et la fiabilité opérationnelle.

Aujourd’hui, dbt s’intègre dans :

L’automatisation, la reproductibilité et l’indépendance vis-à-vis des technologies propriétaires.

Des architectures Data Mesh, où chaque domaine conserve la responsabilité de ses données.

Le pilotage de la qualité, de la traçabilité et de la conformité.

Coalesce 2025 : dbt change d’échelle grâce à l’IA, à la fusion et à la performance

L’événement Coalesce 2025 a marqué un net tournant technologique et une accélération stratégique :

Fusion dbt + Fivetran : vers une expérience intégrée de l’ingestion à la transformation, permettant une gouvernance et une cohérence de bout-en-bout dès la source.

Fusion Engine : nouveau moteur Rust haute performance, piloté par une orchestration intelligente “state-aware”. Résultat : seule la donnée impactée est retraitée, d’où des gains de productivité massifs (jusqu’à 60 % de temps en moins, 45 % de coûts d’infra économisés selon les premiers cas clients).

dbt Agents : l’avènement d’intelligences artificielles embarquées dans l’expérience dbt. Ces agents assistent la génération, refactorisation, documentation, monitoring et diagnostic des pipelines. Leur atout majeur : tout est traçable et documenté, safe by design.

Renforcement de l’ouverture et du standard : poursuite de l’évolution du format open MCP (Manifest Change Protocol), compatibilité multi-cloud et multi-tools, pour rester indépendant tout en connectant tous vos outils BI, catalogues et IA.

dbt va ainsi bien plus loin qu’une simple boîte à outils SQL : c’est désormais un pilote intelligent, orchestrant tout le cycle de vie des pipelines analytiques, vers l’entreprise AI-centric.

dbt : catalyseur d’une data fiable, agile et tournée vers l’IA

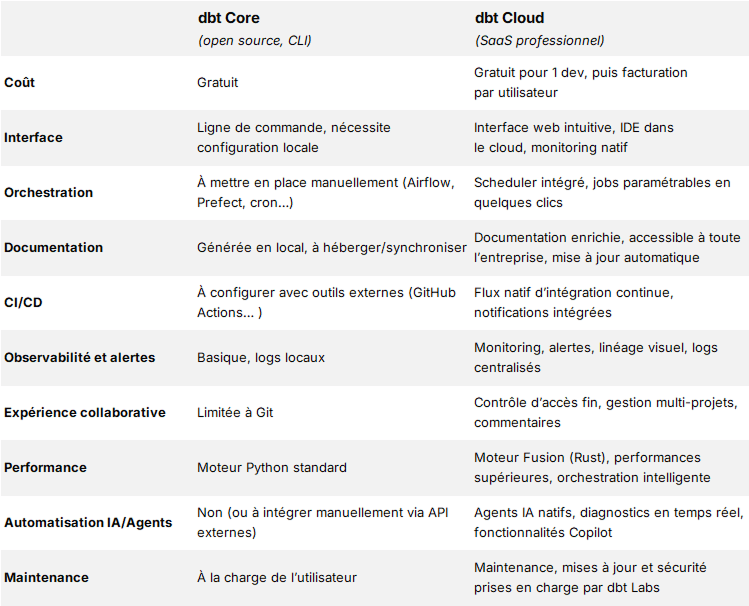

Avec dbt, la transformation de vos données devient fiable, gouvernée et reproductible. Les modèles s’organisent en dépendances claires, chaque transformation est documentée automatiquement et des tests systématiques contrôlent la qualité sans intervention manuelle. Grâce à l’orchestration intelligente qui n’exécute que les modèles concernés, les temps de traitement et la consommation cloud sont significativement réduits. dbt Cloud ajoute une interface collaborative, des diagnostics automatisés par IA, et une maintenance simplifiée. La mise en production d’indicateurs ou de nouveaux flux analytiques est plus rapide, les erreurs sont détectées en amont, et chaque évolution technique est maîtrisée.

En optant pour dbt et un accompagnement expert comme ActinVision, vous industrialisez vos pipelines data tout en préparant votre SI aux nouveaux usages analytiques et de l’intelligence artificielle, avec un cadre solide pour l’innovation et la maîtrise opérationnelle.